自動運転の車が当たり前になる時代も、もうすぐそこまできていますね。

自分がハンドルを握らなくもAIが勝手に運転してくれるなんて、映画の中のような話ですが、

もし事故に直面した場合、そのロボットがとった行動は正しいと言えるでしょうか?

早速ですが、まずはあなたの心を試す2択問題です!

どうして自分がそれを選ぶのか考えてみてください^^

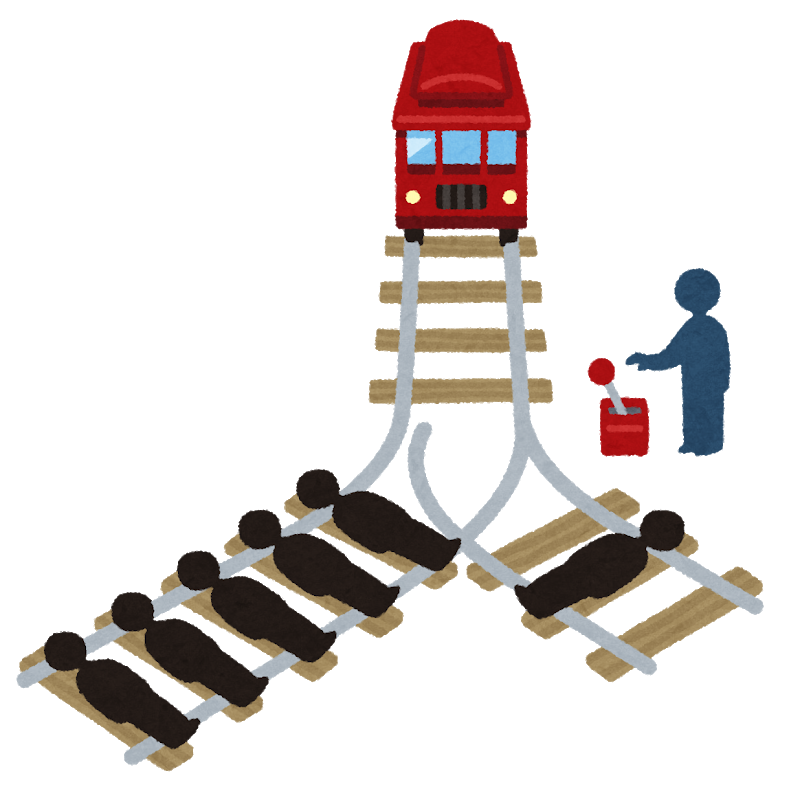

シチュエーション1

あなたは線路のレバーを切り替える係の人です。

あなたの判断で電車が進む方向が決まります。

一つの線路の上で5人の作業員が線路の工事をしています。

もう一つの線路では1人の作業員が作業をしています。

レバーを切らず、そのまままっすぐ運転すると、5人をひき殺してしまいます。

レバーを切ったら、1人を引き殺してしまいます。

さて、あなたはどちらを選びますか?

※作業員の年齢/性別/人種などは考えず、ただの一人の人間として考えてください!

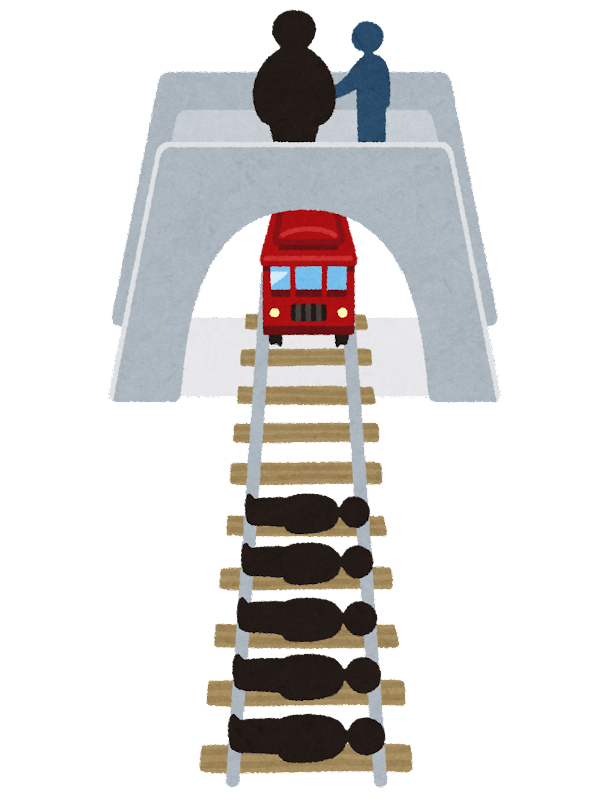

シチュエーション2

あなたは橋の上に、もう一人の人と立っています。

橋から見える先の方の線路の上で5人が作業をしています。

そして、あなたは橋の上から電車がその5人に向かってきているのが見えています。

もしあなたが、あなたと一緒に橋の上にいる人を突き落として電車を止めれば、5人の命は助かります。

あなたはその人を突き落として、5人を助けますか?

それとも何もせず、5人がひき殺されるのを見ていますか?

※橋の上に立っている人、作業員の年齢/性別/人種などは考えず、ただの一人の人間として考えてください!

結果

このテストに正解はありません!

結果だけを見ると、どちらのシチュエーションも、1人の人を救うか、5人を救うかというお話なんです。

でも面白いことに、

シチュエーション1では、ほとんどの人が抵抗なく、1人をひき殺すことを選ぶんです。

でもシチュエーション2では、ほとんどの人が、橋から人を突き落とすことに抵抗があるんです。

みなさん、自分の答えはどうでしたか?

そして、どうして結果は同じなのに答えが違うんでしょうか?どうして自分はそれを選んだか、自分の中で考えてみてください!

実はこれ、トロッコ問題という哲学です!面白くないですか?これは倫理観の問題です。(何を良しとするかの判断思考)

この倫理観は人によって様々なので、一概にこうだからとは言えませんが、シチュエーション1では、誰かが死ぬという状況は変えることができない中で、「より多くの人を助ける」という結果重視で1人の人を殺すことを選ぶ人が多いんです。シチュエーション2では、橋の上の人は、何もされなければ生きているという状況で、この人を殺してほかの人を助けるというのは、道徳的に間違っているという考えが働くといいます。

なので、この質問に対してほとんどの人が、何の罪のない人を端から突き落として、5人の命を救おうというのはただの人殺しだ!と思うそうです。

自動運転の車(AI技術)と哲学

ここからが本題です!

上で考えた哲学が自動運転のAI技術のなかでも取りあげられています。

自動運転の車がどうにも避けられない事故に直面したとき、AIは何を選択するのか?ということです。

マサチューセッツ工科大学では、Moral Machine といって、あらゆる事故を想定した場面で、人がどういう選択をするのかということをテストしています。

このテスト面白くて、本当にこんな場面あるのかよ!って突っ込みたくなるんですが、

でも、路上で何があるかわからないですよね。

自動運転の車が、誰か/もしくは動物を殺さなくてはいけない場面もないとは言い切れません!

きっとこれからデータをとって、自動運転の車がより人間に近い判断ができるようにプログラミングしていくんだと思います!

※自分の倫理観がわかって面白いので、是非やってみてください!

Webサイトはこちら。(日本語です!)

最後に

AIに人の倫理観を持ち込むってすごいですよね。でも、間違いなく必要ですよね^^

わかりやすい例でいうと、

ヘルメットをかぶっている人か、かぶっていない人に追突しなければ自分が死んでしまうという場面で、ヘルメットをかぶっている人を選ぶとします。

だって、ヘルメットをかぶっているから助かる可能性は高いわけですよね。

”より多くの人が助かる方を選ぶ”とプログラミングした場合、この自動運転は正しく機能しているので問題ありません。

でも、人間はこんな風にも考えませんか?

そのヘルメットをかぶっている人は交通ルールをしっかり守っているのに、どうしてその人を守らず、ルール違反者を事故から守らなきゃいけないの?もしくは、自分が犠牲になれば、両方の命が助かるかもしれない…。

この倫理観を基にした判断は、プログラミングでは難しいかもしれないですよね。

だからこそ、哲学をAIに持ち込むことは不可欠なんです^^

プログラマーの人たちはすごいですよね!

おまけに

倫理観の問題もそうですが、もし自動運転の車が事故を起こした場合、誰が責任をとるのか、ここもなかなか大きなテーマですね。

あるユダヤ人の哲学者が言っていますが、ナチス・ドイツ時のユダヤ人虐殺に関わった人たちにインタビューをしたところ、

「私はガスを運んだだけです」「建物の設計をしました」

っていう答えばかりだったんですって。

結局のところ、誰が悪いのかわからなかったんです。

この哲学者は、”誰もが犯罪に加担する可能性がある。”と言っています。

これは、この自動運転だけではなくSNSの発言など、色々なところでも通じることですよね。

最後、少し話はずれましたが、今回は哲学とAIのお話でした^^

少しでも、哲学の重要性を分かってもらえればうれしいです!